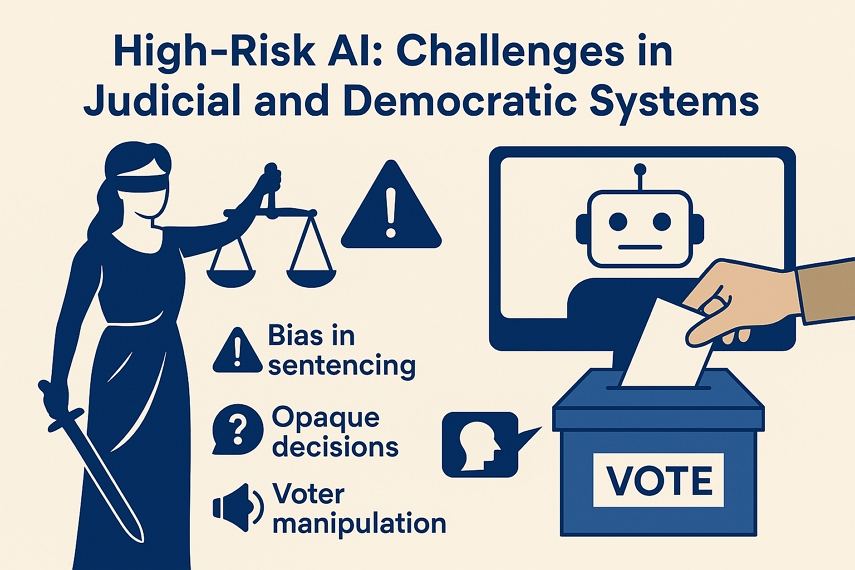

AIは民主主義の味方?それとも敵?AI裁判の運用例とリスク

AIリスク評価ツールが人種バイアスにより米国の被告人を誤って「高リスク」と分類した事例(ProPublica,2016年)や、動画がブラジルの2022年選挙を左右したケースでは、世界が敏感分野におけるAIの暗い可能性を目の当たりにしました。EU AI法案が「AI裁判」や民本主義に関するAIシステムを「高リスク」と分類するのは、まさにこうしたミスが基本的権利と社会的信頼を脅かすためです。

このような敏感分野では、公平性、透明性、人権を犠牲にせずにAIのパワーを活用するにはどうすればよいのでしょうか。本稿では、現在の活用状況、重大なリスク、高リスク領域におけるAIの責任ある活用戦略について詳しく見ていきます。

パート1.高リスク領域における現在のAIの活用

AIはますますさまざまな分野の意思決定システムに組み込まれています。司法や民本主義の場面では、それが速度と効率を約束しますが、それには代価が伴います。

1.司法システムにおける活用

- 法律文書分析: AIは数千もの法律文書を処理することで、事件準備を効率化します。

- 予測型警察活動: PredPolなどのアルゴリズムが潜在的な犯罪予測エリアを地図上で表示します。

- リスク評価ツール: 米国のCOMPASアルゴリズムは再犯リスクを推定し、保釈や量刑判断の参考になります。

- 自動証拠処理: AIは監視映像やデジタルデータの中から関連アイテムを見つけるのを支援します。

- バーチャル裁判官: DoNotPayなどのAIチャットボットは、小額請求や上訴を会話形式で処理します。

2.民本的プロセスにおける活用

- 有権者行動予測: 選挙キャンペーンでAIを使って有権者の動向や意見を追跡します。

- ターゲット型政治広告: マイクロターゲティングにより、ハイパーパーソナライズされた政治メッセージが可能になります。

- ディズインフォメーションボット: AI生成コンテンツが自動的に誤解を招く叙述を拡散します。

- コンテンツモデレーション: プラットフォームはAIを配置して敏感な政治的発言を自動フラグ付けや削除を行います。

- 選挙予測: 予測モデルがキャンペーン戦略や有権者の期待に影響を与えます。

パート2.重大なリスク:なぜEUがこれらを「高リスク」と指定するのか

EU AI法案の高リスク分類は、AIが基本的権利を害し、公的信頼を侵食し、個人の自由に影響を与える可能性に根ざしています。司法や民本主義では、そのリスクが特に高いのです。

1. 司法特有の脅威

- バイアスの拡大: 過去の法律データで訓練されたAIは、既存の格差を強化する可能性があります(例:量刑における人種バイアス)。

- 透明性の欠如: 「ブラックボックス」モデルは、結果を説明できないまたは抗弁できない場合、正当法律手続きを侵害します。

- 説明責任の空白: エラーが発生した場合、開発者、機関、アルゴリズムのどちらが責任を負うのか明確ではありません。

2.民本主義特有の脅威

- 世論操作: アルゴリズム設計による宣伝が叙述を変えます。

- 制度的信頼の侵食: ディズインフォメーションとAIによる混乱が選挙や民本的システムへの信頼を低下させます。

- デジタル的排除: バイアスのあるアルゴリズムは特定のコミュニティを疎外したり、少数派の意見を抑圧する可能性があります。

3.領域横断的な危険

- データの悪用: 敏感な生体認証データや行動データが無断で使用される可能性があります。

- セキュリティ脅威: 公共インフラのAIシステムはサイバー攻撃の標的となりやすいです。

- 過度な依存: AIへの過剰な依存は、人間の批判的思考と監視機能を弱体化させる可能性があります。

パート3.これらの分野でAIを使用する際の主なリスク

AIの効率性にはトレードオフが伴います。特に公平性、正義、民本主義がかかっている分野ではその傾向が強いです。

1.司法システムにおけるリスク

- 量刑バイアス: 欠陥のあるデータで訓練されたAIは、制度的な差別を永続化または悪化させる可能性があります。

- 意思決定の不透明性: AIによる判決はしばしば説明可能性が欠如しており、法律の透明性を損ないます。

- 人間の判断の侵食: 裁判官や弁護士がアルゴリズムの推奨に過度に依存すると、状況に応じた細部が軽視される可能性があります。

2.民本的システムにおけるリスク

- AI生成コンテンツによる操作: フェイクビデオ、改ざんされた画像、誤解を招くニュースが有権者の判断を左右する可能性があります。

- 選挙信頼の喪失: AIが叙述を形成する役割が隠されていると、人々は結果を信頼しなくなる可能性があります。

- マイクロターゲティングによる極端化: AIが有権者のバイアスに共鳴するコンテンツを提供することで、社会的分裂を悪化させます。

パート4.軽減策:EU AI法案への準拠

EU AI法案は高リスクAIの活用に一連のセーフガードを義務付けています。準拠は単なる法的要件ではなく、倫理的な要件でもあります。

1.義務付けられたセーフガード

- 人間による監視: AIは人間の検証なしに最終決定を下すべきではありません。

- バイアステストと透明性ログ: 開発者はモデルの監査を行い、意思決定ロジックを開示する必要があります。

- データガバナンス: すべてのデータ使用はGDPR基準と倫理的な同意慣行に適合する必要があります。

2.前向きなベストプラクティス

政府向け:

- 独立したアルゴリズム監査:第三者評価により中立性と正確性を確保します。

- 公的AI登録制度:市民はどの高リスクシステムがどこで活用されているかを知る必要があります。

法律専門家向け:

- 説明可能なAI(XAI)の使用:ツールは出力に対して明確で解釈可能な正当化を提供する必要があります。

- バイアスの継続的監視:承認されたシステムでも回帰を避けるために継続的な監査が必要です。

結論

司法や民本主義にAIを導入するには、準拠だけでは不十分です。倫理的な注意が必要です。ツールは人間の判断を強化するべきで、置き換えるべきではありません。EU AI法案の第1条が私たちに思い起こさせるように:「AIは人間をサーブするべきで、逆ではありません。」AIを採用する機関は、透明性監査(例:HitPaw VikPeaの準拠型バイアス検出)と複数利害関係者による統治を最優先すべきです。そうして初めて、Loomisv.Wisconsinのような不当行為を防ぎ、民本主義をアルゴリズムによる破壊から守ることができるのです。

HitPaw FotorPea

HitPaw FotorPea HitPaw VoicePea

HitPaw VoicePea HitPaw Univd

HitPaw Univd

この記事をシェアする:

「評価」をお選びください:

松井祐介

編集長

フリーランスとして5年以上働いています。新しいことや最新の知識を見つけたときは、いつも感動します。人生は無限だと思いますが、私はその無限を知りません。

すべての記事を表示コメントを書く

製品また記事に関するコメントを書きましょう。