Wan AI Wan 2.1:マルチモーダルAI創作の次世代進化版

Wan 2.2はマルチモーダルAIクリエイティブにおけるマイルストーンとなります。アリババのWan AIチームによって開発されたこのオープンソースモデルは、総計270億個、アクティブ140億個のパラメータを備えたMixture-of-Expertsアーキテクチャを活用し、RTX 4090などのコンシューマーGPUで720p、さらには1080p、24fpsのシネマ品質の動画を生成します。テキストから動画、画像から動画の両方のワークフローをサポートし、効率化のために高圧縮VAE技術を融合し、Wan 2.1に比べて拡張された学習データによってパフォーマンスを向上させています。

この記事では、Wan AI Wan 2.2の主なブレイクスルー、クリエイティブ機能の強化、コアアプリケーション、使用ガイド、推奨される動画強化ツールを詳しく探り、その最大のポテンシャルを引き出すために必要なすべての情報を提供します。

パート1. Wan AI Wan 2.2の紹介:技術的なブレイクスルーは何ですか?

Wan 2.2は、マルチモーダルAIクリエーションにおいてWan 2.1から大幅な飛躍を遂げています。高度なアーキテクチャ革新とクリエイティブ機能を統合したツールキットを提供し、効率的なリソース要件とオープンソースのアクセシビリティを備えた状態で、テキストまたは画像からシネマ品質の動画を生成できるようにしています。

Wan AI Wan 2.2における技術的なブレイクスルー

- マルチモーダル入力:テキストから動画(T2V - A14B)と画像から動画(I2V - A14B)をサポートし、テキストプロンプトまたはアップロードされた画像から動画を生成できます。

- 高解像度動画生成:24fpsで720p HD動画(480pも可)を生成します。例えば、T2V-1.3Bモデルは約8GBのVRAMを搭載したコンシューマーGPUで動作し、RTX 4090で5秒間の480p動画を約4分で生成します。

- オーディオ-ビジュアルリップシンク:正確な唇の形状の同期を伴うリアルなオーディオを生成し、より生き生きとした動画体験のためのスマートなプロンプト拡張機能を備えています。

- アーキテクチャ上の利点:MoE(Mixture-of-Experts)、Flash Attention 3、高圧縮VAE(約64倍)を使用して、総計約270億個のパラメータ(ステップごとに140億個がアクティブ)で構築されています。MoEは、モーション、照明、シーン構成などの側面に特化したエキスパート間でタスクを分割し、高速な推論を保証します。

パート2. Wan AI - Wan 2.2の主な機能とハイライト

Wan AI Wan 2.2は印象的な技術仕様だけでなく、画像、動画、エフェクト、ワークフロー全体のクリエイティブな制御を洗練させています。シネマ的な美学、最適化されたモーション一貫性、カスタム学習サポート、クロスモーダルな流れ、スマートなツールを備えており、イラストレーターからアニメーターまで、さまざまな分野のクリエイターがより高品質なコンテンツをより容易かつ正確に制作できるようにしています。

画像生成:より精緻化、より制御可能化

Wan AI Wan 2.2は、肌、布地、風景などの質感における詳細なレンダリングを強化するとともに、正確なスタイル制御(照明、彩度、構図)を提供します。スマートな構図提案は、プロジェクト固有のキャラクターやコンセプトアートを迅速に作成するのに理想的です。

動画生成:よりスムーズなモーションエフェクト

Wan 2.2におけるモーションは、より滑らかでリアルです。特に時間的な一貫性を改善してチラつきを減らし、シーン間のよりスムーズな遷移をサポートし、より長く、高解像度のクリップをより効率的に処理するため、ショートフォームのクリエイターやストーリーボード駆動型のワークフローに最適です。

特殊効果:よりリアルで多様化

Wan AI Wan 2.2は、シネマレベルの照明制御、煙や火などのリアルなパーティクルエフェクト、スタイル化されたフィルタープリセット、プロンプトに基づく自動エフェクト提案をサポートしています。これらの機能は、ドラマチックなビジュアルを求めるゲーム開発者やマルチメディアアーティストに特に役立ちます。

LoRAトレーニング:より効率的かつ高精度化

Wan 2.2には、LoRA微調整のための簡素化されたサポートが含まれています。より高速なトレーニング速度、わずか10~20枚の画像によるフューショットラーニング、パラメータ調整のためのより直感的なビジュアルインターフェースを実現しており、プロジェクト全体で一貫したアートスタイルの生成が必要なスタジオに適しています。

クロスモーダルクリエーション:シームレスな統合

このモデルは画像と動画の生成を結びつけます:静止画像をアニメーション化(風に揺れる葉、動くキャラクター)したり、スタイルを保持したまま動画から静止フレームを抽出したりすることができます。これにより、キャンペーン要素全体でビジュアルの一貫性を維持します。

クリエイティブアシスタンス:スマートなツール

Wan AI Wan 2.2には、リアルタイムパラメータプレビュー、拡張されたプリセットライブラリ(アニメ、リアリズム、広告)、スマートなデフォルト提案などのインテリジェントなクリエイティブ機能が追加されています。これらの加速ツールは、ブレインストーミングと反復をより速く行うのを助けます。

パート3. Wan AI - Wan 2.2のアプリケーションシナリオ

Wan AI Wan 2.2は、高品質な動画/画像生成と柔軟な制御を組み合わせており、多くのプロフェッショナルなユースケースに適しています。マーケティング、教育、クリエイティブアーツ、Eコマース、ビジネスのいずれにおいても、このモデルはビジュアルストーリーテリングとコンテンツ制作を効率化します。

- マーケティング&広告:魅力的なプロモーション動画、製品デモ、ソーシャルメディアコンテンツを作成し、ブランドの可視性を向上させます。

- 教育&トレーニング:生き生きとしたビジュアル形式で教育教材、チュートリアル、トレーニング動画を制作します。

- クリエイティブコンテンツ:音楽、アート、ストーリーテリングに最適で、強化されたインスピレーションをもって芸術的なビジョンを現実に変えます。

- Eコマース:動画を介して製品を動的に展示し、消費者の注意を引きつけて売上を促進します。

- ビジネスプレゼンテーション:スライドデッキを魅力的な動画に変換し、より説得力のあるプレゼンテーションを行います。

パート4. Wan AI - Wan 2.2を使用して画像から動画を生成する方法

Wan AI Wan 2.2の使用を開始するのは簡単でアクセスしやすいです。GitHubからモデルをダウンロードするか、ComfyUIの組み込みサンプルテンプレートを使用するかにかかわらず、迅速にテキストまたは画像からシネマ品質の動画を生成し始めることができます。ステップバイステップのワークフロー手順により、プロセスは簡素化され、生成されたMP4出力はすぐに編集または公開することができます。

Wan 2.2 14Bモデルを使用して画像から動画を生成するステップ

このワークフローは、入力画像を動画に変換します。20GBのVRAMを必要とし、RTX4090 GPUカードで約1時間20分かかります。

ステップ1:ComfyUIを更新

上部ツールバーからComfyUI Managerを開き、「ComfyUIを更新」を選択します。最新バージョンとテンプレートサポートを確保するために、ComfyUIを再起動します。

ステップ2:Wan-2.2ワークフローを読み込み

ワークフロー > テンプレートを閲覧 > 動画 > 「Wan2.2 14B I2V」に移動します。または、公式のWan AI Wan 2.2 JSONワークフローをダウンロードしてComfyUIキャンバスにドラッグアンドドロップします。

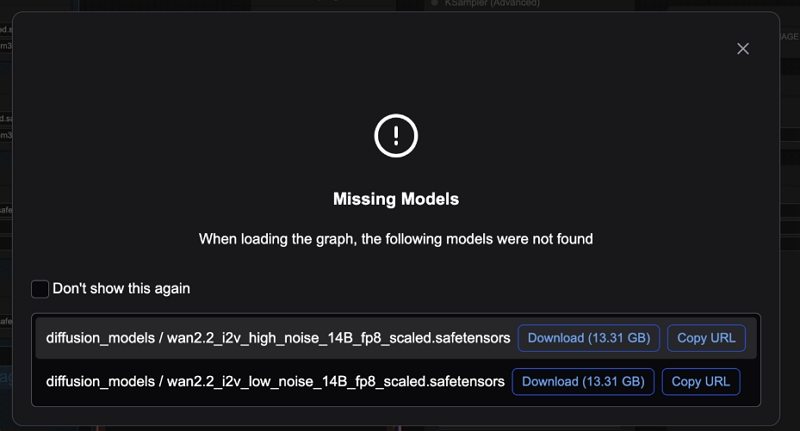

ステップ3:モデルファイルをダウンロードして整理

ワークフローJSONファイルを読み込んだ後、ComfyUIから不足しているモデルファイルのダウンロードを促すメッセージが表示されるはずです。

ダウンロードする必要があるファイルは以下の通りです:

- wan2.2_i2v_high_noise_14B_fp8_scaled.safetensorsをダウンロードし、ComfyUI > models > diffusion_modelsに配置します。

- wan2.2_i2v_low_noise_14B_fp8_scaled.safetensorsをダウンロードし、ComfyUI > models > diffusion_modelsに配置します。

- umt5_xxl_fp8_e4m3fn_scaled.safetensorsをダウンロードし、ComfyUI > models > text_encodersに配置します。

- wan_2.1_vae.safetensorsをダウンロードし、ComfyUI > models > vaeに配置します。

ステップ4:ノードでモデルが正しく読み込まれていることを確認

ワークフローノードで:

- 最初の「拡散モデルを読み込み」ノードをハイノイズモデルに設定

- 2番目のノードをローノイズモデルに設定

- 「CLIP(テキストエンコーダー)を読み込み」ノードでumt5_xxl_fp8...を使用していることを確認

- 「VAEを読み込み」ノードでwan_2.1_vae.safetensorsを使用していることを確認

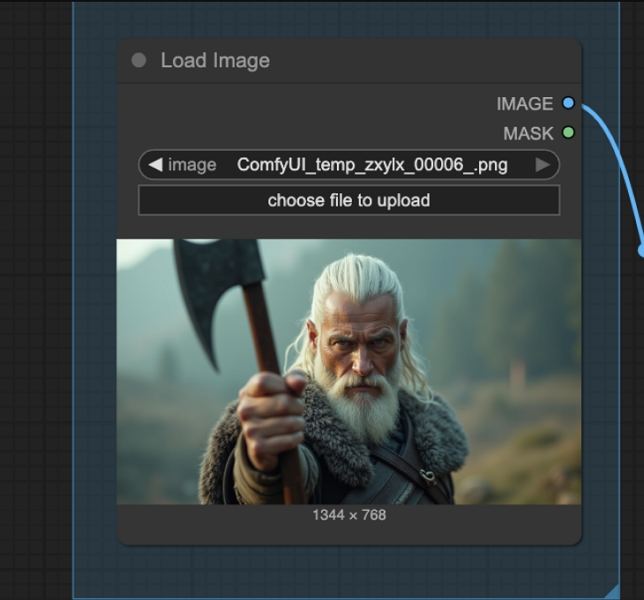

ステップ5:入力(画像または開始フレーム)をアップロード

「画像を読み込み」ノードを使用して、動画の最初のフレームとなる画像をアップロードします。

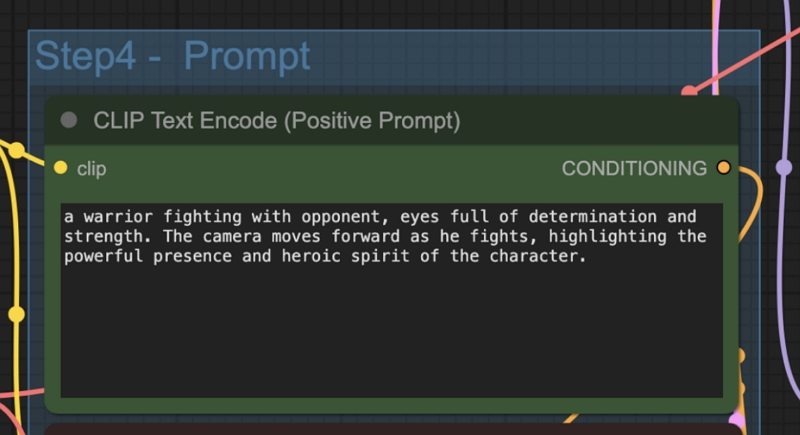

ステップ6:プロンプトを修正して設定をカスタマイズ

CLIPテキストエンコーダーノードを介してポジティブプロンプトとネガティブプロンプトの両方を編集します。必要に応じて、EmptyHunyuanLatentVideoノードの設定(寸法、長さなど)を使用して動画サイズとフレーム数を調整します。

ステップ7:ワークフローを実行して動画を生成

「実行」ボタンを押すか、Ctrl(またはCmd)+ Enterを使用して生成を開始します。ComfyUIは動画シーケンスを処理してMP4形式にレンダリングします。

コミュニティによるWan AI - Wan 2.2の使用ヒント

- ComfyUI内のネイティブワークフローは、外部ラッパーノードを回避し、ComfyUI Managerを介してインストール可能なT2VモードとI2Vモードの両方をサポートします。

- VRAMの少ない環境の場合は、1.3Bモデルバリアントを考慮してください。これは8GBカード(RTX 3060など)でも使用可能です。

- ComfyUIインターフェースに赤いノードまたは不足しているノードが表示される場合は、ComfyUI Manager → 不足しているカスタムノードをインストールを実行してください。特にKijaiのWanVideoWrapperまたは関連するヘルパースイートについてです。

- TeaCacheまたはSage Attentionモードを使用して、より大きなGPUで生成速度を向上させ、メモリ使用量を削減します。

動画チュートリアル:Wan AI Wan 2.2 VS Google Veo 3 | 無料でWan 2.2を使用する方法 - オープンソースAI動画ジェネレーター

関連情報. HitPaw VikPeaで生成された動画出力を強化

Wan AI Wan 2.2によって生成された動画を磨くために、HitPaw VikPeaはAI駆動型の強化ツールを提供し、出力品質をプロフェッショナルレベルに引き上げます。シネマクリップの調整から低解像度フッテージの修復まで、VikPeaはシャープ化、ノイズ除去、色補正、最大8Kまでのアップスケーリングに優れたパフォーマンスを発揮します。

- AIパイロットモデルが、コンテンツに最適な強化モデルを自動的に推奨します。

- 顔とポートレート強化機能が、顔の鮮明度を向上させ、詳細を正確に復元します。

- 4K-8Kアップスケーリングが、低解像度クリップを鮮明な高解像度動画に変換します。

- 色強化&SDRからHDRへの変換が、鮮やかさとトーンを動的に強化します。

- 低照度強化が、ハイライトを過度に露出させることなく暗いシーンを明るくします。

- 動画修復&背景除去が、グリッチを修正し、不要な要素を削除します。

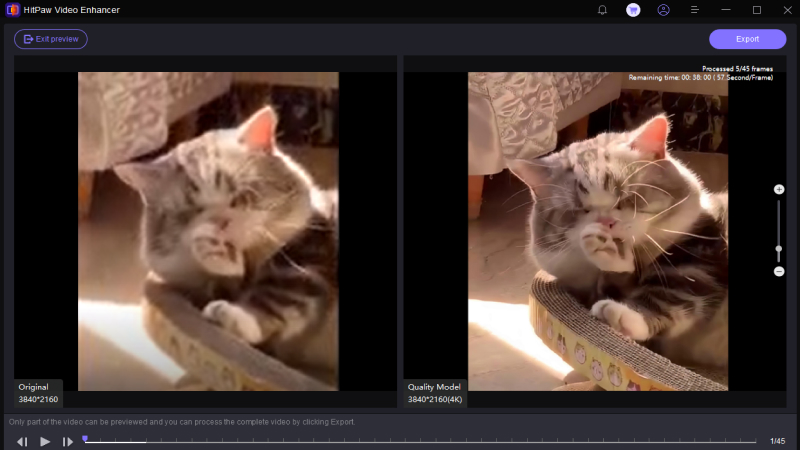

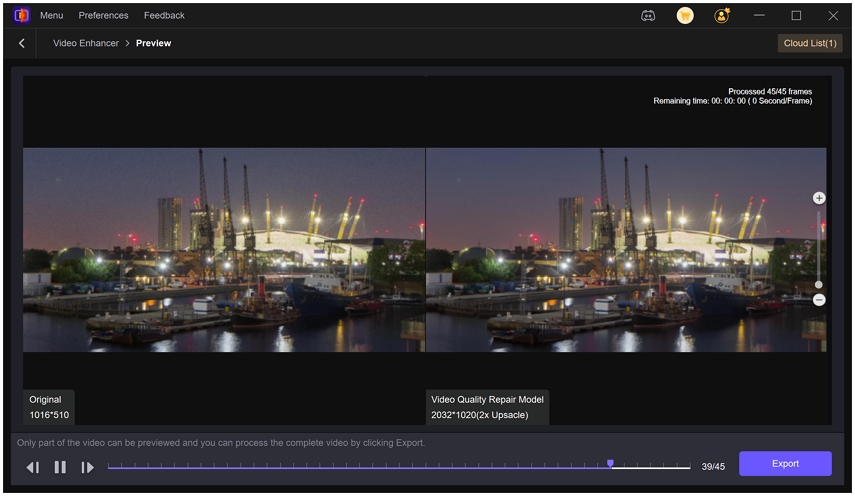

ステップ1.Windows、Mac、またはモバイルプラットフォームにVikPea Video Enhancerをインストールします。「ファイルを選択」またはドラッグアンドドロップでWan AI Wan 2.2によって生成された動画をインポートします。

ステップ2.動画を強化するモデルを選択します。このソフトウェアは、一般モデル、シャープモデル、ポートレートモデル、動画品質修復モデルなどの複数のAIモデルを提供します。ニーズに基づいて適切なモデルを選択します。

ステップ3.完全にエクスポートする前に、3~5秒のクリップで強化効果をプレビューします。ライセンスを取得している場合は、最大8K解像度で最終動画をエクスポートします。

結論

Wan AIのWan 2.2は、マルチモーダルAIクリエーションにおける画期的な一歩を刻みました。MoEアーキテクチャ、高解像度出力、同期されたオーディオ-ビデオ、効率的なLoRAトレーニングといった技術的なブレイクスルーに加え、洗練されたクリエイティブ機能とクロスモーダル機能により、マーケティング、教育、アート、Eコマースなど、さまざまな分野のクリエイターに力を与えています。

完全にオープンソースでアクセス可能なWan 2.2は、シネマコンテンツを生成するための効率的で柔軟なツールキットを提供します。HitPaw VikPeaのようなツールと組み合わせることで、プロフェッショナルレベルの動画調整が可能になります。プロフェッショナルであっても愛好家であっても、Wan 2.2はビジュアルストーリーを生成して配信する方法を変革する可能性があります。

コメントを残す

HitPaw の記事にレビューを作成しましょう